Qué es un prompt y por qué importa. Un prompt es el texto (o entrada multimodal) que el modelo usa para predecir una respuesta específica. No necesitas ser científico de datos para escribir uno, pero muchos factores influyen en su eficacia: el modelo, su configuración, las palabras y el tono, la estructura y el contexto. Por eso, crear prompts es un proceso iterativo; prompts imprecisos generan respuestas ambiguas o poco útiles.

El ciclo iterativo del prompt perfecto. Diseñar prompts de calidad implica probar, medir y refinar: optimizar longitud, estilo y estructura, e ir ajustando hasta lograr el resultado deseado. Documenta tus intentos y los cambios de configuración para que tus mejoras sean reproducibles.

Configura la salida del modelo (temperature, top-K, top-P, tokens)

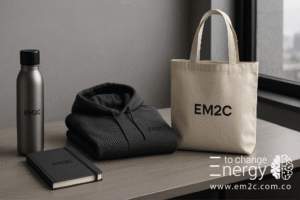

Temperature: creatividad vs. constancia. Temperature controla el “azar” al elegir el siguiente token. Temperaturas bajas favorecen respuestas más deterministas; altas favorecen variedad. A 0, la decodificación es codiciosa (greedy). Subirla demasiado hace que casi todos los tokens sean igual de probables.

Top-K y Top-P: control de diversidad. Top-K limita la elección a los K tokens más probables; Top-P (nucleus) usa una probabilidad acumulada. Ambos ajustan creatividad/precisión, y conviene experimentar para ver cuál rinde mejor en tu caso.

Cómo interactúan. Dependiendo del modelo, primero se filtran candidatos por Top-K/Top-P y luego se aplica temperature. En extremos, un ajuste puede volver irrelevantes los otros (p. ej., temperature=0 o Top-K=1).

Longitud máxima y coste. Generar más tokens cuesta más cómputo y tiempo; limitar la salida evita derroches y, en técnicas como ReAct, frena tokens “de relleno”. También puedes pedir explícitamente una extensión deseada en el prompt.

Punto de partida recomendado: temperature 0.2, top-P 0.95, top-K 30 (ajústalo según tarea). Para más creatividad: ~0.9/0.99/40; para más precisión: ~0.1/0.9/20. Si hay una única respuesta correcta, empieza con temperature 0.

Técnicas de prompting esenciales

Zero-shot: empieza simple. Zero-shot describe la tarea sin ejemplos; es lo más rápido para comprobar si el modelo “entiende” tu pedido.

One-shot & Few-shot: enseña con ejemplos. Añadir uno o varios ejemplos guía al modelo hacia el patrón deseado. Como regla general, usa 3–5 ejemplos para tareas complejas (según la longitud límite). Incluye edge cases y cuida la calidad; pequeños errores confunden.

System, Role y Context: orquesta el comportamiento.

- System define el propósito global (qué debe hacer).

- Context aporta detalles inmediatos de la tarea.

- Role fija el tono y la “personalidad” de la respuesta.

Distinguirlos te ayuda a combinar y analizar su efecto en la salida.

Razonamiento avanzado

Chain of Thought (CoT). Pide “piensa paso a paso” para obtener razonamientos intermedios y mejorar la exactitud en problemas complejos. (Se incluye como técnica clave del whitepaper).

Self-Consistency. Ejecuta el razonamiento varias veces (con temperatura alta), extrae respuestas y elige la más frecuente para ganar coherencia. (Listada entre técnicas destacadas).

Tree of Thoughts (ToT). En vez de una cadena lineal, explora múltiples rutas de pensamiento en “árbol” para problemas que requieren exploración. (Listada entre técnicas destacadas).

ReAct (Reason + Act). Combina razonamiento en lenguaje natural con acciones (p. ej., buscar, ejecutar código) en bucles pensamiento-acción-observación para resolver tareas complejas. (Listada entre técnicas destacadas).

Buenas prácticas para prompts que escalan

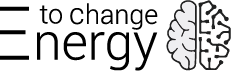

Sé específico con el output. Indica formato, estilo y criterios de aceptación (p. ej., “devuelve JSON válido con campos X/Y/Z”). Las instrucciones claras elevan la precisión.

Usa instrucciones más que restricciones. Es más efectivo decir qué debe hacer que sólo listar lo que no debe hacer.

Usa verbos de acción. “Analiza, Extrae, Clasifica, Resume…” ayudan a enfocar la tarea.

Usa variables y plantillas. Estandariza prompts con placeholders (p. ej., {ciudad}), así reutilizas y automatizas.

Controla la longitud. Ajusta max tokens o pide una extensión concreta (“en 150 palabras”).

Experimenta con formato y estilo. A veces una pregunta, una instrucción o una afirmación producen salidas distintas; prueba y compara. Mezcla el orden de clases en few-shot de clasificación.

Documenta, evalúa y versiona. Lleva tus prompts al código como artefactos versionados, con plantillas de documentación y pruebas automáticas para evaluar generalización.

Formato “Universal” : como escribir el mejor prompt (COPY/PASTE)

# META

Objetivo: [Describe el resultado exacto en 1 frase]

Audiencia: [Quién usará la salida]

Criterios de calidad: [p. ej., factual, actualizado, tono X]

Restricciones: [p. ej., no opiniones, sin datos inventados]

Formato de salida: [JSON|Tabla|Markdown], máx. [N] tokens

# CONFIG (si tu plataforma lo permite)

temperature=[0.2], top_p=[0.95], top_k=[30], max_tokens=[N]

# SYSTEM

Eres [ROL] y ayudas a [OBJETIVO]. Sigue exactamente el formato requerido.

Si faltan datos, pregunta o marca "UNKNOWN". Evita texto extra.

# CONTEXT

Datos relevantes:

- [Hechos/Reglas 1..N]

- [Definiciones/Glosario]

# EXAMPLES (opcional few-shot)

Entrada: "<ejemplo 1>"

Salida: <formato correcto>

Entrada: "<ejemplo 2>"

Salida: <formato correcto>

# TASK

Tarea: [Acción concreta con verbos de acción]

Entrada del usuario: "<TEXTO/CONSULTA>"

Devuelve SOLO el [FORMATO] solicitado.Plantillas listas (copy/paste) como escribir el mejor prompt

Copia, pega y personaliza. Estas plantillas siguen las mejores prácticas y están pensadas para ser el punto de partida de como escribir el mejor prompt en múltiples escenarios.

1) Clasificación (Zero/Few-shot + formato estricto)

[SYSTEM]

Eres un asistente que clasifica textos en {CLASES}. Devuelve SOLO JSON válido.

[CONTEXT]

Reglas:

- Devuelve {"label": "<CLASE>","confidence":"<0-1>"}.

- Si la clase no es clara, devuelve "label": "UNKNOWN".

- Máximo 60 tokens.

[EXAMPLES] (opcional few-shot)

Texto: "<ejemplo positivo>"

Salida: {"label":"POSITIVE","confidence":"0.88"}

Texto: "<ejemplo negativo>"

Salida: {"label":"NEGATIVE","confidence":"0.89"}

[USER]

Clasifica el siguiente texto: "<TEXTO>"

2) Extracción estructurada (JSON Schema + validación)

[SYSTEM]

Devuelve SOLO JSON que cumpla este esquema (sin texto extra).

[SCHEMA]

{

"type":"object",

"properties":{

"persona":{"type":"string"},

"empresa":{"type":"string"},

"fecha":{"type":"string"}

},

"required":["persona","empresa"]

}

[USER]

Extrae los campos del siguiente párrafo: "<PÁRRAFO>"

3) Redacción con voz y restricciones (Role + Style)

[ROLE]

Eres un editor senior con tono claro, humano y persuasivo.

[INSTRUCTIONS]

- Reescribe el texto con 120–150 palabras.

- Añade una metáfora breve.

- Mantén términos técnicos clave.

[USER]

Reescribe: "<TEXTO_ORIGINAL>"

4) Resolución paso a paso (CoT + verificación)

[SYSTEM]

Resuelve problemas matemáticos. Explica "paso a paso" y valida el resultado.

[USER]

Problema: "<PROBLEMA>"

Resuelve paso a paso. Luego valida el resultado con un cálculo alternativo.

5) ReAct (razona y actúa con herramientas)

[SYSTEM]

Puedes usar herramientas: {BUSCADOR|CÓDIGO}. Sigue el bucle:

PENSAMIENTO -> ACCIÓN -> OBSERVACIÓN (repite). Para, sintetiza y responde.

[USER]

Tarea: "<PREGUNTA_COMPLEJA>"

Objetivo: responde con fuentes citadas.

6) Plantilla de documentación de prompt (para tu repositorio)

Name: [nombre y versión]

Goal: [objetivo en una frase]

Model: [modelo y versión]

Temperature: [0–1] Token Limit: [n]

Top-K: [n] Top-P: [0–1]

Prompt: [prompt completo]

Output(s): [salidas de ejemplo]

(Basado en una plantilla de documentación recomendada en el whitepaper.)

Preguntas frecuentes (FAQ)

1) ¿Por qué mi prompt devuelve resultados inconsistentes?

Porque los sampling settings (temperature, top-K, top-P) añaden aleatoriedad. Baja temperature o restringe Top-K/Top-P; para tareas con única respuesta, usa temperature 0.

2) ¿Cuántos ejemplos pongo en few-shot?

Como regla práctica, 3–5 ejemplos; para tareas más complejas, quizá más, teniendo en cuenta el límite de entrada.

3) ¿Cómo logro más creatividad sin perder coherencia?

Sube ligeramente temperature/top-P/top-K y añade instrucciones claras y formato de salida (JSON/tabla) para acotar la respuesta.

4) ¿Qué diferencia hay entre System, Role y Context?

System define el propósito; Context aporta datos de la tarea; Role fija estilo/voz. Puedes combinarlos según tu objetivo.

5) ¿Cómo controlo costes y latencia?

Limita la longitud de salida (max tokens) y pide respuestas breves cuando sea posible; el texto extra cuesta cómputo.

6) ¿Plantillas o prompts nuevos cada vez?

Usa plantillas con variables; facilitan la reutilización, automatización y pruebas. Documenta versiones y resultados.

7) ¿Cuándo usar como escribir el mejor prompt con CoT, ToT o ReAct?

- CoT: problemas que requieren razonamiento paso a paso.

- ToT: exploración de múltiples caminos.

- ReAct: cuando necesitas razonar y además consultar herramientas/datos.

Conclusión y siguientes pasos

Dominar como escribir el mejor prompt es una habilidad iterativa: define objetivos claros, elige la técnica adecuada (zero/few-shot, System/Role/Context, CoT/ToT/ReAct), controla sampling y longitud, usa plantillas con variables, y documenta para mejorar con cada ciclo. Así, transformarás tus interacciones en resultados fiables y útiles.

Recurso recomendado: Introducción a Prompt Design (Google Cloud)

Si necesitas información adicional o asistencia personalizada Contáctanos o visita nuestra sección Soluciones IA